AUFLÖSUNG

8,3 MP (3840 x 2160)

OBJEKTIV

4,0 mm

SINGLE-SENSOR

1/1,8″ CMOS

Die CX810 von Reolink ist mit einem 1/1,8-Zoll-CMOS Bildsensor ausgestattet und bietet eine 4K UHD Auflösung mit 3840 × 2160 Pixeln. Somit ergibt sich eine maximale Sensorpixelanzahl von 8,3 MP.

Die Kamera besitzt eine feste Objektiv Brennweite von 4,0 mm und eine Blendenzahl von F1.0. Dabei ist generell zu beachten, dass die Blende eines Kameraobjektivs nicht nur die Belichtung, sondern auch die Schärfentiefe, also den Bereich im Bild, der scharf dargestellt wird beeinflusst. Bei der richtigen Kameraauswahl ist zu berücksichtigen, dass eine große Blendenöffnung, also eine niedrige Blendenzahl wie beispielsweise F 1.0 zu einer geringen Schärfentiefe führt. Dies bedeutet, dass nur ein kleiner Bereich des Motivs im Fokus scharf abgebildet werden, während der Vorder- und Hintergrund unscharf erscheint. Bei der Reolink CX810 ist diese Blendenzahl erforderlich um die Vollfarbnachtsicht mittels ColorX zu gewährleisten.

Der Betrachtungswinkel beträgt bei der Reolink CX810 horizontal 93,2° (HFOV) und vertikal 48,2° (VFOV). Daraus ergibt sich ein diagonales Sichtfeld von 111,6°. In Verbindung mit dem Objektiv, dem Sensor wie den anderen technischen Spezifikationen ergibt sich für die Kamera eine Erkennungsreichweite, nach DIN EN 62676-4, von bis zu 15 Meter bei 125 Pixel pro Meter. Die Reichweite für die Identifizierung von Menschen wie Objekten liegt bei etwa 8 Meter.

Eine Systemintegration in andere Systeme ist möglich. ONVIF® wird von der Reolink CX810 unterstützt. Die volle Leistungsfähigkeit der Kamera entfaltet sich jedoch nur mit der Reolink eigenen Software, welche für verschiedene Betriebssysteme zur Verfügung steht.

Die Kamera ist mit vier 3000 Kelvin Spotlights ausgestattet. Die Farbtemperatur ist damit dem warmweißen Lichtspektrum zuzuordnen. Der Lichtstrom, also die gesamte Menge an sichtbarem Licht, die von der Reolink CX810 laut Herstellerangaben ausgestrahlt wird, beträgt 400 Lumen. Eine Infrarotbeleuchtung ist nicht vorhanden.

Die Reolink CX810 unterstützt neben der Videokomprimierung H.264 auch High Efficiency Video Coding (H.265), um Speicherplatz und Bandbreite zu sparen. Für die Spannungsversorgung wird nach dem PoE-Standard IEEE 802.3af ein Anschluss der Klasse 3 (PoE Class 3) für eine maximale Leistungsaufnahme von 12 W benötigt. Darüber hinaus besteht zudem die Möglichkeit, die Kamera über einen separaten 12 V DC Anschluss mit 1 Ampere zu betreiben.

TEST

Reolink CX810

Getestet wurde die Reolink CX810 mit einer festen Brennweite von 4,0 mm

VERPACKUNG

Die Reolink CX810 wird in einem zweckmäßigem Karton mit der Aufschrift „Be Prepared, Be Reolink“ geliefert. Auf der Verpackung befindet sich die Seriennummer der Kamera. Im Inneren wird die Überwachungskamera wie das Zubehör mittels Schaumstoff gut geschützt.

Zum Lieferumfang gehören neben einer allgemeinen Installationsanleitung und den Informationen bezüglich der Garantie auch umfangreiches Montagezubehör. Dieses besteht u. a. aus einem 1 Meter langem Patchkabel, wetterfeste Verschraubungen für selbiges, einer Schaumstoff-Montageunterlage, Schrauben wie Dübel und 5 „24 HOUR VIDEO SURVEILLANCE“ Warnaufklebern.

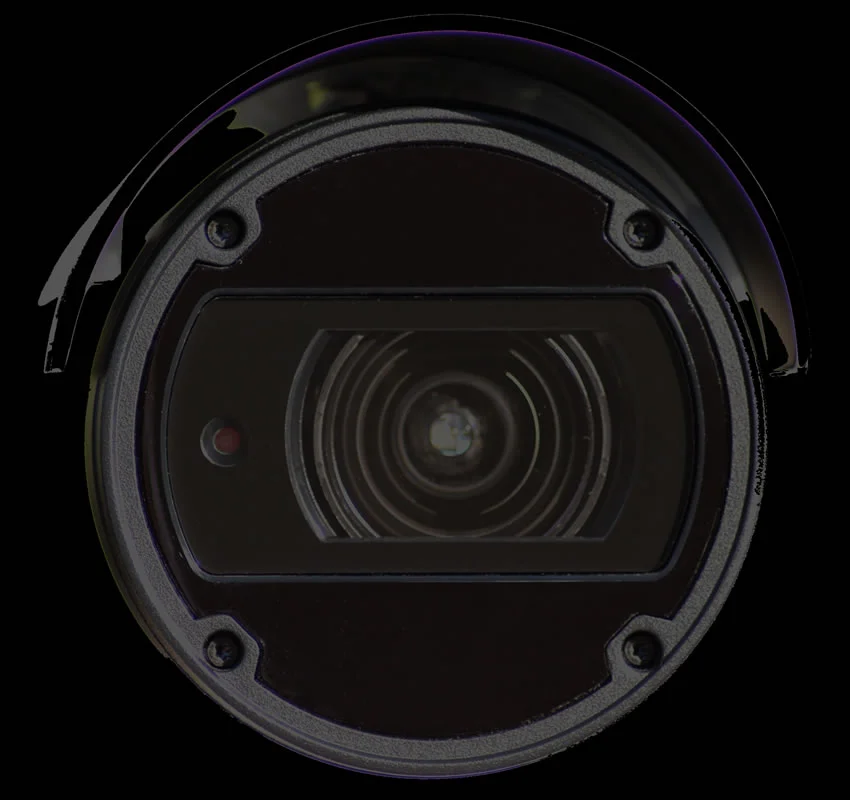

KAMERAMODUL Reolink CX810

Bei der Reolink CX810 handelt es sich um eine Single-Sensor Bullet Kamera für die Aufputz Montage mit einem 4,0 mm Objektiv. Das Kameramodul mit der Kamerahalterung bilden eine Einheit. Das Kameragehäuse besteht aus Aluminium. Die Reolink CX810 Videosicherheitskamera wird über ein Systemkabel versorgt, welches geschützt durch die Kamerahalterung läuft. Die Kamera kann u. a. hängend wie stehend montiert werden.

Das Kamerasystemkabel besitzt 2 Anschlüsse wie einen Taster. Einen 12 V DC Buchsen-Anschluss, einen RJ45 PoE-Netzwerkanschluss und einen Reset-Knopf zum Zurücksetzen der Kamera.

Die Kamera kann über POE oder 12 V DC mit Spannung versorgt werden. Dies ist sehr hilfreich und birgt in sich eine Redundanz bei der Spannungsversorgung der Kamera.

Die Kamerafrontscheibe ist in zwei Bereiche geteilt. Der innere Bereich für das Objektiv und der äußere Bereich für die 4 LED-Spotlights. Der Objektivring trennt diese beiden Bereiche. Die Spotlights sorgen bei Nacht für Farbaufnahmen und werden bei einbrechender Dunkelheit automatisch aktiviert.

Unsere umfangreichen Tests haben die Leistungsfähigkeit der ColorX-Technologie bewiesen. Die Kamera liefert bei Einbruch der Dunkelheit sehr lange farbige Bilder ohne die Aktivierung der LEDs. Erst bei vollkommener Dunkelheit und bei steigendem Bildrauschen werden die 4 LED-Spotlights hinzugeschalten. Über die Reolink-Software ist es möglich die Spotlights zu deaktivieren. Dies wird von unserer Seite aus aber nur empfohlen wenn die Umgebungsbeleuchtung diese Maßnahme rechtfertigt, da ohne Weißlicht-Zusatzbeleuchtung das Bildrauschen bei Dunkelheit sehr stark ansteigt. Diese Fähigkeit der Reolink CX810 hat uns veranlasst in einem Kurzvideo die Frage zu stellen: „Ist dies die beste Überwachungskamera für unter 150 Euro?„

Grundsätzlich ist festzuhalten, dass Bildrauschen in Videoüberwachungskameras die Bildqualität erheblich beeinträchtigen können, besonders unter schlechten Lichtverhältnissen. Dieses Rauschen entsteht durch die Unzulänglichkeiten des Sensors der Kamera, wenn dieser versucht, das wenige vorhandene Licht zu verstärken. Hohe ISO-Werte oder geringe Sensorqualität können das Rauschen verstärken. Moderne Überwachungskameras verwenden verschiedene Technologien wie 3D-Rauschunterdrückung, die die Bildklarheit verbessern, indem sie das Rauschen reduzieren, ohne wichtige Details zu verlieren. Die Wahl der richtigen Kamera mit fortschrittlichen Rauschreduktionstechnologien ist entscheidend für die Erzielung klarer Videoaufnahmen.

Bei der Verstärkung von Bildsignalen in Videokameras tritt häufig das Problem auf, dass neben den gewünschten Details auch kleine Bildfehler verstärkt werden. Diese werden als Bildrauschen sichtbar und beeinträchtigen die Bildqualität. Bildrauschen kann die Klarheit und Schärfe des Bildes reduzieren, was besonders in Überwachungs- oder professionellen Aufnahmesituationen problematisch ist. Zudem führt verstärktes Rauschen zu einem erhöhten Bedarf an Bandbreite für die Videostreams, da mehr Daten übertragen werden müssen, um das rauschende Bild zu verarbeiten. Dies kann die Effizienz des Videostreaming-Systems beeinträchtigen und zusätzliche Kosten verursachen.

Wenn das zufällige Rauschen in Videobildern verstärkt wird, beeinträchtigt dies die Bildqualität erheblich. In Bildern, wo Pixelwerte durch Rauschen abweichen, erscheinen normalerweise einheitlich gefärbte Bereiche körnig und unscharf. Dies führt dazu, dass solche Bilder für Überwachungszwecke unbrauchbar werden können, da wichtige Details und Konturen nicht mehr klar erkennbar sind. Dieses Problem stellt insbesondere bei Sicherheitsanwendungen eine Herausforderung dar, wo klare und deutliche Bildwiedergabe essenziell ist.

Moderne Kameras und Überwachungsgeräte nutzen automatische Anpassungen von Blendenöffnung, Verschlusszeit und Verstärkung, um sicherzustellen, dass das erzeugte Bild stets korrekt belichtet wird. Die Blendenöffnung reguliert die Lichtmenge, die auf den Sensor fällt, während die Verschlusszeit bestimmt, wie lange Licht auf den Sensor einwirkt. Die Verstärkung erhöht bei Bedarf die Lichtempfindlichkeit, um dunkle Szenen aufzuhellen. Durch die automatische Abstimmung dieser drei Parameter können die Geräte schnell auf wechselnde Lichtverhältnisse reagieren und sorgen so für eine optimale Bildqualität, unabhängig von den Umgebungsbedingungen.

Das Reolink CX810 Kameramodul besitzt auf der Rückseite einen microSD-Steckplatz. Es können SD-Karten bis maximal 256GB verarbeitet werden.

MicroSD-Karten sind für Videoüberwachungskameras eine wichtige Speichermöglichkeit, die es ermöglicht, Videomaterial direkt auf der Kamera zu speichern, ohne dass ein externer Netzwerkvideorekorder (NVR) oder eine Cloud-Verbindung erforderlich ist. Diese Karten sind besonders nützlich für die lokale Speicherung, wenn eine zuverlässige Internetverbindung fehlt oder eine einfache, dezentrale Lösung bevorzugt wird. Speziell für den Einsatz in Überwachungskameras gibt es microSD-Karten mit hoher Schreibgeschwindigkeit und Langlebigkeit, die auch bei kontinuierlichem Schreibbetrieb und unter schwierigen Umgebungsbedingungen eine zuverlässige Leistung bieten. Solche Karten sind häufig widerstandsfähig gegenüber extremen Temperaturen, Wasser und Stößen, was sie ideal für den Einsatz in rauen Außenumgebungen macht. Sie unterstützen oft eine hohe Speicherkapazität, die stundenlange Aufnahmen in hoher Auflösung ermöglicht, und bieten somit eine praktische und flexible Option zur Datenspeicherung für Sicherheitsanwendungen.

Zudem ist die Reolink CX810 ist mit einem integrierten Mikrofon und Lautsprecher ausgestattet. Es ist beispielsweise möglich über die Reolink-App Durchsagen zu tätigen oder einen Alarmton auszulösen. Allerdings sollte die Umgebungslautstärke dabei nicht allzu hoch sein.

Grundsätzlich gilt in Deutschland: Tonaufnahmen sind bei der Videoüberwachung rechtlich stark eingeschränkt und grundsätzlich nicht erlaubt. Daher ist es wichtig, dass alle Audiofunktionen der Kamera und der verwendeten Software deaktiviert werden, um die gesetzlichen Vorschriften zu erfüllen. Das unerlaubte Aufzeichnen oder Abhören von vertraulichen Gesprächen verstößt gegen § 201 des Strafgesetzbuches (StGB) und kann strafrechtlich verfolgt werden.

Dieser Gesetzesparagraph schützt das „nichtöffentlich gesprochene Wort“ und dient dem Schutz der Privatsphäre. Wer ohne Erlaubnis Tonaufnahmen anfertigt oder weitergibt, setzt sich einem erheblichen rechtlichen Risiko aus, das Geldstrafen oder sogar Freiheitsstrafen nach sich ziehen kann. Daher ist es entscheidend, dass die Audioaufzeichnungs- und Abhörfunktionen der Überwachungskamera abgeschaltet sind, um rechtliche Konsequenzen zu vermeiden. Überprüfe unbedingt die Einstellungen sowohl an der Kamera als auch in der zugehörigen Software, um die gesetzlichen Bestimmungen vollständig einzuhalten.

Das Kameramodul selbst misst einen Durchmesser von 67 mm bei einer Länge von 100 mm, mit der Kamerahalterung misst die Reolink CX810 eine Gesamtlänge von 187 mm, das Gewicht wird laut Datenblatt mit 467 g angegeben. Das Kameragehäuse besitzt keine IK-Stoßfestigkeitsgrad Zertifizierung.

Der Temperaturbereich wird bei der Kamera laut Datenblatt von -10°C bis 50°C angegeben. Je nach Montage und Einsatzbereich, muss dies berücksichtigt werden. In Westeuropa können im Winter Temperaturen von gut -20°C auftreten, dies würde unter Umständen, an einem nicht wettergeschützten Bereich, ein Problem für die Kamera darstellen.

Die Reolink CX810 ist eine klassische Smart-Home-Überwachungskamera welche auf kurze Distanzen, auch in der Nacht, gute Bilder liefert.

KAMERAHALTERUNG

Die Kamera Positionierung erfolgt intuitiv über die Halterung. Einstellknopf gegen den Uhrzeigersinn drehen, um die Halterung zu lösen und die Kamera in die gewünschte Richtung zu bewegen. Nach der Ausrichtung Einstellknopf im Uhrzeigersinn drehen, um die Kamera zu fixieren. Die Kamerahalterung ist fest mit dem Kameramodul verbunden. Über die Halterung läuft das Systemkabel welches den Stromanschluss wie den Netzwerkanschluss für das Kameramodul realisiert. Zudem wird über das Systemkabel, wie bereits weiter oben erwähnt, der Reset-Taster für die Kamerarücksetzung, aus der Reolink CX810 geführt.

hochverfügbare allwettertaugliche

SICHERHEITSLÖSUNGEN

24 - 7 - 365

Tag | Nacht | Schlechtwetter

INBETRIEBNAHME + SOFTWARE + WEBINTERFACE

Die Inbetriebnahme der Reolink CX810 erfolgt entweder über die Reolink-Software oder über Google Home.

Die Google Home-Funktion bezieht sich auf eine Vielzahl von Funktionen und Fähigkeiten, die mit einem Google Home-Gerät oder einem Gerät mit integriertem Google Assistant möglich sind. Google Home ist ein intelligenter Lautsprecher, der mit dem Google Assistant arbeitet – einem virtuellen Assistenten, der auf Sprachsteuerung basiert. Die Google Home-Funktion bietet eine Vielzahl von Möglichkeiten. Die Software zeichnet sich durch eine unkomplizierte Installation aus.

Die Reolink-Software gibt es für verschiedene Betriebssysteme. Unterstützte Betriebssysteme sind bei PCs Windows und Mac OS sowie bei Smartphones iOS und Android. Hervorzuheben ist, dass die App-Versionen für Android und iOS keine explizierten Berechtigungen benötigen.

Eine erfolgreiche Inbetriebnahme mit der vollen Leistungsbandbreite der Kamera wird nur gelingen, wenn die Reolink CX810 selbst wie die Reolink-App bzw. der Reolink-Client mit dem Internet verbunden sind.

Die Softwareinstallation auf einem PC wie einem Smartphone ist denkbar einfach. Am sinnvollsten geht man auf die Reolink Downloadseite und wählt das gewünschte Betriebssystem zum Download aus.

Im Folgenden betrachten wir die Reolink-Installation für ein Windows Betriebssystem.

Nach dem Download der Software und dem Aufruf der exe-Datei wird der Reolink-Windows-Client installiert. Nach der Installation erfolgt ein automatischer Abgleich, ob eine neuere Version vorhanden ist.

Um nun ein neues Gerät, eine neue Überwachungskamera, hinzuzufügen wird die UID-Nummer der jeweiligen Kamera benötigt. Eine UID (Unique Identifier) ist ein 16-stelliger Code, der als eindeutige Identifikationsnummer für eine Kamera dient und speziell für die Fernverbindung über das Internet genutzt wird. Durch die Eingabe der UID in den Reolink-Client oder die die Reolink-App kann das Gerät problemlos hinzugefügt und konfiguriert werden, sodass man jederzeit und von überall einen Fernzugriff darauf hat. Diese Funktion ermöglicht eine bequeme und sichere Verwaltung der Überwachungsgeräte, ohne dass eine komplexe Netzwerkkonfiguration erforderlich ist.

Die UID-Nummer findet man auf der Kamera unterhalb des QR-Codes. Für die PC-Client Variante muss der Code abgelesen und händisch eingetippt werden. Bei der Verwendung der App-Variante über ein Smartphone, kann der QR-Code, welcher die UID-Nummer darstellt, bequem über die Smartphone-Kamera eingelesen werden.

Wurde die Kamera mit der eingegebenen UID im Internet gefunden, erfolgt die Eingabe für Benutzername wie Passwort. Dabei gilt für die Ersteinrichtung: Der Standardbenutzer von Reolink-Geräten ist admin, und das Standardpasswort ist kein Passwort, also das Feld der Passworteingabe bleibt im ersten Schritt leer.

Nachfolgend muss zwingend ein Passwort gesetzt werden, wobei gilt, je komplexer umso besser. Das Passwort sollte idealerweise aus Groß- wie Kleinbuchstaben, Zahlen und Sonderzeichen bestehen und aus unserer Sicht mindestens 16 bis 30 Zeichen lang sein. Siehe auch:

Hat man mal das Passwort nicht mehr parat, bietet die Reolink CX810 über den Reset-Knopf des Systemkabels die Möglichkeit, die Kamera zurück zu setzen.

Nach Passworteingabe besteht die Möglichkeit, den Benutzername wie den im Netzwerk angezeigten Namen der Kamera zu ändern.

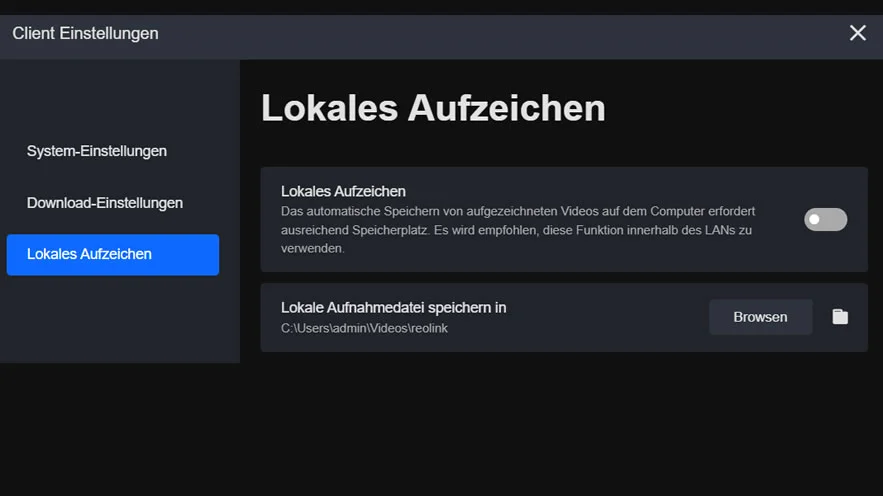

Der Reolink PC-Client bietet 3 Hauptkategorien mit deren Hilfe die Client-Konfiguration vorgenommen werden kann. Diese 3 Hauptkategorien sind die allgemeinen System-Einstellungen, die lokalen Download-Einstellungen wie die Einstellungen für das lokale Aufzeichnen.

NUTZUNG | HAFTUNG

Trotz sorgfältiger Kontrolle übernehmen wir keine Gewähr für die Richtigkeit und Vollständigkeit der Inhalte.

Vergleich mit Standard Full HD Kamera

[ERKENNEN 125 Px/m]

Erklärung prozentuale Darstellung: Die maximale Distanz für ERKENNEN entspricht 100 %. Alle anderen Werte werden prozentual daran ausgerichtet.

Beispiel: max. ERKENNEN = 31 m = 100 %. Min. ERKENNEN = 15 m dies entspricht 100 % * 15 m / 31 m = 48 %

[IDENTIFIZIEREN 250 Px/m]

Erklärung prozentuale Darstellung: Die maximale Distanz für IDENTIFIZIEREN entspricht 100 %. Alle anderen Werte werden prozentual daran ausgerichtet.

Beispiel: max. IDENTIFIZIEREN = 15 m = 100 %. Min. IDENTIFIZIEREN = 8 m dies entspricht 100 % * 8 m / 15 m = 53 %

für Hersteller

Sie möchten Ihr Produkt auf CCTV-check listen?

AV1-Codec

Der AV1-Codec ist ein moderner, lizenzfreier Videokompressionsstandard, der von der Alliance for Open Media (AOMedia) entwickelt wurde, um eine hocheffiziente, plattformübergreifende und kostenfreie Alternative zu H.265 (HEVC) und VP9 zu bieten. Durch seine fortschrittlichen Kompressionsalgorithmen ermöglicht AV1 eine bis zu 30 % bessere Bitratenreduktion im Vergleich zu H.265, ohne dabei die Bildqualität zu beeinträchtigen. Dies macht ihn besonders attraktiv für Streaming-Dienste, Video-on-Demand-Plattformen und WebRTC-Anwendungen, da er sowohl 4K- als auch 8K-Videos mit HDR und High Dynamic Range (HDR10+ und Dolby Vision) effizient verarbeitet.

Da der Codec Open Source und lizenzfrei ist, wird er bereits von großen Technologieunternehmen wie Google, Netflix, YouTube und Twitch unterstützt und gilt als eine der wichtigsten Technologien für die Zukunft des bandbreitenoptimierten Streamings, der Gaming-Übertragung und der Videokonferenzen. Dank seiner hohen Effizienz und breiten Hardware-Unterstützung bietet AV1 eine nachhaltige Lösung für datenintensive Videoanwendungen, insbesondere in Zeiten steigender Streaming-Anforderungen und wachsender globaler Netzwerknutzung.

INHALTSVERZEICHNIS

AV1-Codec: Schnellere Downloads und effizientes Streaming durch verbesserte Kompression

Der AV1-Codec zeichnet sich durch seine überlegene Kompressionseffizienz aus, die im Vergleich zu älteren Standards wie H.265 (HEVC) oder VP9 rund 30 % mehr Datenreduktion ermöglicht. Dies bedeutet, dass Videoinhalte mit gleicher Bildqualität bei geringerer Dateigröße übertragen werden können, was wiederum die benötigte Bandbreite erheblich senkt. Besonders für Streaminganbieter, Cloud-Dienste und mobile Anwendungen ist dies ein entscheidender Faktor, da Nutzer durch AV1 schnellere Ladezeiten und flüssigere Wiedergabe selbst bei instabilen oder langsamen Internetverbindungen erleben.

Da die Downloadzeiten durch die effizientere Kompression verringert werden, profitieren insbesondere Nutzer mit begrenzten Datenvolumen oder schwacher Netzabdeckung, wie es oft in ländlichen Gebieten oder bei mobilen Netzwerken der Fall ist. Streaming-Plattformen wie Netflix, YouTube oder Twitch können durch den Einsatz von AV1 die Datenübertragungskosten senken, ohne die Videoqualität zu beeinträchtigen, und gleichzeitig ein optimales Nutzererlebnis auf unterschiedlichsten Geräten bieten.

Besonders bei hochauflösenden Inhalten wie 4K und 8K-Videos, HDR-Streaming oder Virtual Reality (VR)-Anwendungen entfaltet AV1 sein volles Potenzial, da hier die Reduktion der Bandbreitennutzung noch stärker ins Gewicht fällt. Zudem erlaubt die bessere Effizienz adaptive Bitraten, wodurch Videos dynamisch an die verfügbare Internetgeschwindigkeit angepasst werden – ein entscheidender Vorteil für Live-Streaming und hochauflösende Cloud-Gaming-Dienste.

Insgesamt ermöglicht AV1 durch reduzierte Dateigrößen und verkürzte Downloadzeiten eine kosteneffiziente, schnelle und qualitativ hochwertige Videoübertragung, die sowohl für Streaminganbieter als auch für Endnutzer eine erhebliche Verbesserung darstellt.

Höhere Videoqualität bei geringerer Bitrate für optimales Streaming

Ein wesentlicher Vorteil des AV1-Codecs gegenüber älteren Formaten wie H.264 (AVC) und VP9 ist seine überlegene Videoqualität, die auch bei niedrigen Bitraten erhalten bleibt. Während herkömmliche Codecs oft zu sichtbaren Kompressionsartefakten, Unschärfe oder Blockbildung führen, nutzt AV1 modernste Algorithmen zur effizienten Kodierung und Rauschunterdrückung, um auch bei reduzierter Datenrate eine hohe visuelle Qualität zu gewährleisten. Das bedeutet, dass selbst bei schlechter Netzwerkverbindung oder begrenzter Bandbreite klare, detailreiche Bilder mit weniger sichtbarer Pixelbildung möglich sind.

Diese Verbesserung ist insbesondere für mobile Nutzer und Cloud-Plattformen von Bedeutung, da AV1 es ermöglicht, hochwertige Videos mit geringerer Datenmenge zu übertragen. Dadurch profitieren auch Endnutzer, die bei langsameren Internetverbindungen oder mobilen Datenlimits flüssiges Streaming in besserer Qualität genießen können.

Ein weiterer Vorteil von AV1 ist die effiziente Handhabung von Bewegungen und komplexen Szenen, was besonders in Sportübertragungen, Gaming-Streams oder actionreichen Filmen eine entscheidende Rolle spielt. Wo ältere Codecs oft mit Artefakten oder Detailverlusten kämpfen, sorgt der AV1-Codec durch verbesserte Bewegungsvorhersage, adaptive Schärfung und fortschrittliche Farbkompression für ein klareres und flüssigeres Seherlebnis.

Insgesamt ermöglicht der AV1-Codec eine signifikante Verbesserung der Videoqualität bei gleichzeitig geringeren Bitraten, wodurch Streaming-Dienste Kosten für Bandbreite sparen, während Nutzer weniger Datenvolumen verbrauchen, ohne Kompromisse bei der Bildqualität eingehen zu müssen.

AV1 und die Herausforderung der Codierungszeit: Hohe Effizienz, aber langsame Verarbeitung

Ein wesentlicher Nachteil des AV1-Codecs ist die deutlich langsamere Codierungszeit, die insbesondere bei der Verarbeitung großer Videodateien eine Herausforderung darstellt. Im Vergleich zu älteren Formaten wie H.265 (HEVC) benötigt AV1 in vielen Fällen bis zu dreimal mehr Zeit, um ein Video mit derselben Auflösung und Qualität zu komprimieren. Dies liegt daran, dass AV1 komplexere Algorithmen und fortschrittlichere Kompressionstechniken verwendet, um eine bessere Bildqualität bei geringerer Bitrate zu erreichen. Während dies zwar die Datenübertragung und Streaming-Effizienz verbessert, bedeutet es gleichzeitig eine höhere Rechenlast für Encoder und verlängerte Verarbeitungszeiten.

Besonders für Content-Produzenten, Streaming-Dienste und Medienunternehmen, die täglich große Mengen an Videomaterial kodieren müssen, kann die lange Encodierungszeit zu einem Engpass führen. Höhere Verarbeitungszeiten bedeuten mehr Rechenleistung, höhere Kosten für Serverkapazitäten und längere Wartezeiten, bis Inhalte in AV1 bereitgestellt werden können. Dies kann besonders problematisch sein für Live-Streaming-Plattformen, Nachrichtendienste oder Social-Media-Plattformen, die auf schnelle Bereitstellung von Inhalten angewiesen sind.

Ein weiterer Faktor ist, dass nicht alle aktuellen Hardware-Encoder AV1 vollständig unterstützen, sodass viele Unternehmen auf softwarebasierte Encoding-Lösungen angewiesen sind, die noch langsamer arbeiten als spezialisierte Chips für H.264 oder H.265. Zwar gibt es bereits erste Hardware-Encoder von Intel, NVIDIA und AMD, aber die Verbreitung ist noch nicht weit genug fortgeschritten, um AV1 für alle Anwendungen effizient nutzbar zu machen.

Trotz dieser Nachteile wird erwartet, dass zukünftige Hardware-Optimierungen und leistungsstärkere Encoder die AV1-Codierung in den kommenden Jahren deutlich beschleunigen werden. Bis dahin bleibt AV1 vor allem für Anwendungen attraktiv, bei denen die Effizienz der Wiedergabe und Streaming-Qualität wichtiger ist als die Geschwindigkeit der Kodierung.

AV1-Codec in der Videoüberwachung: Effizientere Speicherung und bessere Bildqualität

Der AV1-Codec bietet erhebliche Vorteile für die Videoüberwachung, insbesondere in Bezug auf Bandbreitenoptimierung, Speicherplatzersparnis und Bildqualität. Da moderne Überwachungssysteme zunehmend auf hochauflösende Kameras (4K, 8K) und Echtzeit-Streaming setzen, wird die effiziente Videokompression zu einem entscheidenden Faktor für Speicherkosten und Netzwerkauslastung. AV1 bietet eine bis zu 30 % bessere Kompression im Vergleich zu H.265 (HEVC), sodass Videoüberwachungssysteme längere Aufzeichnungszeiten ermöglichen können, ohne dass zusätzlicher Speicherplatz benötigt wird.

Ein weiterer Vorteil ist die bessere Bildqualität bei niedrigen Bitraten, was besonders für Kameras mit eingeschränkter Bandbreite oder Remote-Überwachung nützlich ist. In Szenarien mit schwacher Internetverbindung oder drahtloser Datenübertragung sorgt AV1 dafür, dass Überwachungsvideos klar und detailreich bleiben, selbst wenn die Datenrate reduziert wird. Dies ist entscheidend für Anwendungen wie Cloud-gestützte Videoüberwachung, bei der große Datenmengen in Echtzeit an einen entfernten Server gesendet werden müssen.

Zudem verbessert AV1 die Objekterkennung und Analyse durch KI, da die höhere Bildqualität bei niedrigerer Bitrate die Genauigkeit von Bewegungserkennung, Gesichtserkennung und anderen sicherheitsrelevanten Algorithmen erhöht. Besonders in sicherheitskritischen Umgebungen trägt dies dazu bei, Fehlalarme zu reduzieren und effizientere Sicherheitslösungen zu ermöglichen.

Allerdings gibt es noch Herausforderungen, insbesondere in der Echtzeit-Codierung, da AV1 mehr Rechenleistung erfordert als H.265. Dennoch wird erwartet, dass zukünftige Hardware-Beschleunigung und optimierte Encoding-Algorithmen den Einsatz von AV1 in der Videoüberwachung weiter vorantreiben und zu einer neuen Generation von intelligenten, effizienten und kostengünstigen Überwachungssystemen führen.

Fazit: AV1 als zukunftssicherer Videocodec mit großem Potenzial

Der AV1-Codec bietet eine hocheffiziente und zukunftssichere Lösung für die Videokompression, die insbesondere für Streaming-Dienste, Videoüberwachung und datenintensive Anwendungen erhebliche Vorteile mit sich bringt. Durch seine bis zu 30 % bessere Kompression im Vergleich zu H.265 (HEVC) ermöglicht er eine reduzierte Bandbreitennutzung, schnellere Ladezeiten und geringere Speicheranforderungen, ohne dabei die Bildqualität zu beeinträchtigen. Dies macht ihn zu einer idealen Wahl für 4K-, 8K- und HDR-Streaming, Cloud-Gaming sowie KI-gestützte Videoanalysen in der Sicherheitsbranche.

Ein bedeutender Vorteil von AV1 ist zudem seine lizenzfreie Nutzung, die es Unternehmen ermöglicht, ohne hohe Gebühren eine moderne Videokompression zu nutzen. Dies fördert die Verbreitung auf offenen Plattformen und in der Industrie, wodurch AV1 zunehmend von Google, Netflix, YouTube, Twitch und anderen Streaming-Anbietern unterstützt wird. Gleichzeitig sind auch Hardware-Hersteller dabei, AV1 in ihre Grafikkarten, Prozessoren und mobilen Endgeräte zu integrieren, um eine reibungslose Dekodierung zu ermöglichen.

Dennoch gibt es einige Herausforderungen, insbesondere die langsamen Codierungszeiten, die im Vergleich zu H.265 oder VP9 deutlich höher ausfallen. Dies könnte kurzfristig die Verbreitung von AV1 in Bereichen wie Live-Streaming oder Echtzeit-Videoüberwachung einschränken. Allerdings wird erwartet, dass zukünftige Optimierungen in Hardware und Software dieses Problem zunehmend lösen werden.

Insgesamt ist AV1 ein vielversprechender Codec, der die Effizienz und Qualität der Videoübertragung erheblich verbessert, während er gleichzeitig kostengünstiger und nachhaltiger ist als proprietäre Alternativen. Mit der zunehmenden Verbreitung und Unterstützung durch große Unternehmen dürfte AV1 in den kommenden Jahren eine führende Rolle in der Videokompression einnehmen und die Art und Weise, wie Videos gespeichert, gestreamt und analysiert werden, nachhaltig verändern.

NUTZUNG | HAFTUNG

Trotz sorgfältiger Kontrolle übernehmen wir keine Gewähr für die Richtigkeit und Vollständigkeit der Inhalte.

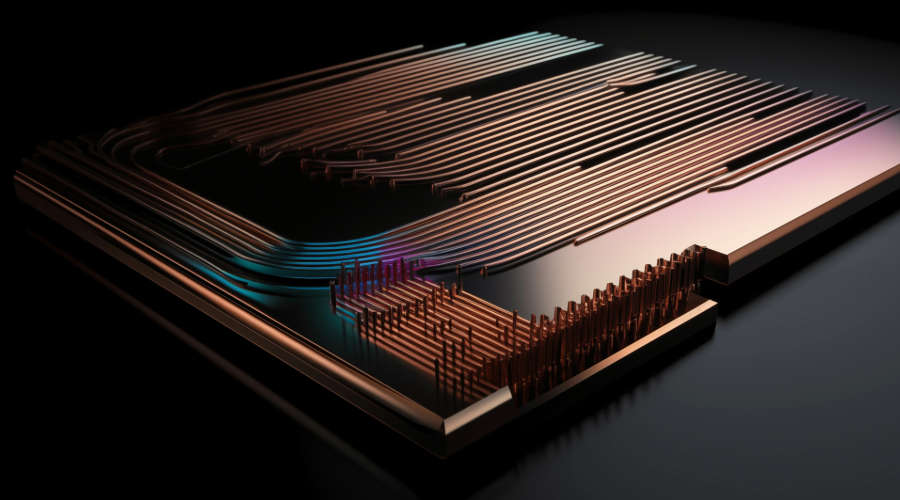

Photonische KI-Chips: Die Zukunft ultraschneller und energieeffizienter KI-Prozessoren

In der Welt der künstlichen Intelligenz und des Hochleistungsrechnens stoßen herkömmliche elektronische Chips zunehmend an ihre Grenzen. Photonische KI-Chips nutzen statt Elektronen Licht (Photonen) zur Datenverarbeitung und ermöglichen dadurch eine extrem hohe Geschwindigkeit, geringeren Energieverbrauch und minimale Wärmeentwicklung. Durch den Einsatz optischer Schaltkreise können neuronale Netzwerke effizienter trainiert, große Datenmengen schneller analysiert und komplexe KI-Anwendungen leistungsfähiger gestaltet werden.

Diese innovative Technologie gilt als Schlüssel zur nächsten Generation von KI-Hardware, die sowohl in Rechenzentren als auch in Telekommunikation, Quantencomputing und autonomer Robotik eine entscheidende Rolle spielen könnte. Photonische KI-Chips revolutionieren die Technologie für ultraschnelle Datenverarbeitung.

INHALTSVERZEICHNIS

Photonische KI-Chips: Geschwindigkeit durch Lichtbasierte Datenverarbeitung

Photonischer KI-Chips haben den Vorteil von extrem hohe Geschwindigkeit, welcher sich aus der Nutzung von Lichtsignalen statt elektrischer Signale ergibt. Während herkömmliche elektronische Chips auf den Fluss von Elektronen angewiesen sind, die durch Leiterbahnen wandern und dabei auf Widerstand sowie Verzögerungen treffen, bewegen sich Photonen nahezu verlustfrei und mit Lichtgeschwindigkeit durch optische Schaltkreise.

Dies reduziert die Latenzzeiten erheblich und ermöglicht es, Datenverarbeitung und Berechnungen in einem Bruchteil der Zeit durchzuführen, die klassische Siliziumchips benötigen würden. Besonders im Bereich künstlicher Intelligenz (KI) und maschinelles Lernen, wo große neuronale Netzwerke enorme Rechenkapazitäten erfordern, können photonische Chips die Trainings- und Inferenzzeiten massiv verkürzen.

Darüber hinaus ermöglichen photonische Chips eine parallele Datenverarbeitung, da Lichtsignale in unterschiedlichen Wellenlängen gleichzeitig verarbeitet werden können – ein Konzept, das als Wavelength Division Multiplexing (WDM) bekannt ist. Diese parallele Signalübertragung führt zu einer exponentiellen Leistungssteigerung, da mehrere Rechenprozesse gleichzeitig stattfinden können, ohne dass es zu Engpässen kommt. Dies macht photonische KI-Chips besonders attraktiv für Hochleistungsrechenzentren, Echtzeit-Analysen und KI-gestützte Entscheidungsprozesse, bei denen Millisekunden über Erfolg oder Misserfolg entscheiden.

Durch diese beispiellose Rechenleistung könnten photonische Chips in Zukunft die Geschwindigkeit moderner KI-Modelle revolutionieren und Anwendungen wie autonomes Fahren, medizinische Diagnostik, Quantencomputing und komplexe Finanzanalysen auf ein völlig neues Level heben.

Energieeffiziente KI: Wie photonische Chips den Stromverbrauch senken

Ein weiterer Vorteil photonischer KI-Chips ist ihr geringerer Energieverbrauch, der sich aus der Nutzung von Licht (Photonen) statt Elektronen zur Datenverarbeitung ergibt. In herkömmlichen Silizium-Chips bewegen sich Elektronen durch Leiterbahnen und erzeugen dabei Widerstand und Wärme, was nicht nur Energieverluste verursacht, sondern auch eine aufwendige Kühlung erfordert.

Photonische Chips hingegen verwenden optische Schaltkreise, in denen sich Photonen verlustfrei und ohne elektrischen Widerstand bewegen, wodurch deutlich weniger Energie verbraucht wird. Diese Energieeffizienz ist besonders vorteilhaft für Anwendungen mit hohem Rechenaufwand, wie maschinelles Lernen, neuronale Netzwerke und Hochleistungsrechnen, da der Energiebedarf von Rechenzentren weltweit kontinuierlich steigt.

Darüber hinaus ermöglicht der geringere Energieverbrauch eine effizientere Nutzung von KI-Technologien an abgelegenen oder energiebegrenzten Standorten, wie beispielsweise in autonomen Fahrzeugen, Edge-Computing-Systemen oder mobilen KI-Geräten. Dies reduziert nicht nur den CO₂-Fußabdruck von KI-Anwendungen, sondern eröffnet auch neue Möglichkeiten für nachhaltige, umweltfreundliche Rechenprozesse. Zusätzlich entfällt der Bedarf an energieintensiven Kühlmechanismen, da photonische Chips kaum Wärme erzeugen, was zu einer weiteren Reduktion des Stromverbrauchs in Rechenzentren führt.

Durch die Kombination aus höherer Geschwindigkeit, paralleler Verarbeitung und Energieeffizienz könnten photonische KI-Chips die nächste große Revolution in der Halbleiterindustrie einläuten und eine völlig neue Ära des leistungsstarken, nachhaltigen Computings einleiten.

Cool Computing: Wie photonische KI-Chips die Hitzeprobleme der Datenverarbeitung lösen

Eine besondere Bedeutung beim Einsatz photonischer KI-Chips ist die geringe Wärmeentwicklung, die sich aus der Nutzung von Licht (Photonen) anstelle von Elektronen zur Datenverarbeitung ergibt. In herkömmlichen Halbleiterchips bewegen sich Elektronen durch Leiterbahnen, was elektrischen Widerstand erzeugt und zu hohen Wärmeverlusten führt. Diese Abwärme muss durch leistungsstarke Kühlsysteme abgeführt werden, was in Rechenzentren und Hochleistungscomputern enorme Mengen an zusätzlicher Energie erfordert.

Im Gegensatz dazu sind photonische KI-Chips nahezu wärmefrei, da Photonen sich ohne Widerstand durch optische Schaltkreise bewegen und somit keine nennenswerte Hitze produzieren. Dadurch reduziert sich nicht nur der Bedarf an energieintensiver Kühlung, sondern auch das Risiko von thermischen Engpässen, die die Leistung herkömmlicher Chips beeinträchtigen können.

Durch die geringere Wärmeentwicklung werden Rechenzentren effizienter und kostengünstiger, da weniger Energie für Lüftung, Klimatisierung und Kühlkörper benötigt wird. Zudem ermöglicht die reduzierte Wärmeproduktion eine höhere Packungsdichte auf einem Chip, da weniger Platz für Kühlmechanismen erforderlich ist, was die Miniaturisierung und Skalierbarkeit photonischer Prozessoren weiter vorantreibt.

Unbegrenzte Skalierbarkeit für die Zukunft der Künstlichen Intelligenz

Photonische KI-Chips bieten eine außergewöhnliche Skalierbarkeit für moderne KI-Modelle, da sie auf parallele optische Berechnungen setzen, anstatt sich auf die begrenzte serielle Verarbeitung herkömmlicher Halbleiter zu stützen. Während klassische elektronische Chips Daten schrittweise verarbeiten, nutzen photonische Chips die Eigenschaft des Lichts, um gleichzeitig mehrere Berechnungen über unterschiedliche Wellenlängen durchzuführen – ein Prinzip, das als Wavelength Division Multiplexing (WDM) bekannt ist. Dies bedeutet, dass ein photonischer Chip viele parallele Berechnungen durchführen kann, ohne durch elektrische Widerstände oder Hitzeentwicklung beeinträchtigt zu werden. Dadurch eignen sich photonische Prozessoren besonders für rechenintensive Anwendungen, bei denen große Datenmengen verarbeitet und Muster erkannt werden müssen.

Gerade in KI-Trainingsprozessen, bei denen neuronale Netzwerke Millionen oder sogar Milliarden von Parametern optimieren müssen, stellt die parallele Verarbeitung photonischer Chips einen enormen Leistungsvorteil dar. Während herkömmliche Halbleiterarchitekturen in ihrer Skalierbarkeit durch Chipgröße, Kühlung und Energieverbrauch begrenzt sind, bieten photonische Chips eine nahezu lineare Leistungssteigerung, indem zusätzliche optische Kanäle genutzt werden können.

Ein weiterer Vorteil ist die modulare Erweiterbarkeit photonischer Chips, die es ermöglicht, sie nahtlos in bestehende Hochleistungsrechenzentren zu integrieren oder spezialisierte KI-Beschleuniger für spezifische Aufgaben zu entwickeln. Da KI-Anwendungen stetig wachsen und immer leistungsfähigere Hardware erfordern, könnten photonische Chips eine entscheidende Rolle in der nächsten Generation von KI-Hardware spielen und die Effizienz von Edge Computing, IoT-Geräten und industrieller KI erheblich steigern.

Zukunft intelligenter und energieeffizienter Videoüberwachung

Die Integration von photonischen KI-Chips in Videoüberwachungssysteme könnte die Branche stark verändern, indem sie eine höhere Verarbeitungsgeschwindigkeit, bessere Bildanalyse und energieeffiziente Echtzeitauswertung ermöglicht. Herkömmliche Überwachungskameras und KI-gestützte Sicherheitslösungen stoßen oft an ihre Grenzen, wenn es darum geht, große Mengen an hochauflösendem Videomaterial in Echtzeit zu analysieren. Photonische Chips ermöglichen eine parallele Verarbeitung mehrerer Video-Streams mit einer extrem niedrigen Latenz. Dies bedeutet, dass Sicherheitsalgorithmen wie Gesichtserkennung, Objekterkennung, Verhaltensanalyse und Kennzeichenerkennung in nahezu Echtzeit ausgeführt werden können, ohne die Rechenleistung herkömmlicher Chips zu überlasten.

Ein weiterer großer Vorteil photonischer Chips ist ihre Effizienz bei schlechten Lichtverhältnissen. Da sie große Datenmengen schneller analysieren können, verbessern sie auch Low-Light- und Nachtsicht-Analysen, wodurch bessere Erkennungsraten in dunklen oder kontrastreichen Szenarien erzielt werden. Dies ist besonders für kritische Sicherheitsbereiche von Bedeutung, wo eine lückenlose Überwachung entscheidend ist. Zudem könnten photonische Chips in Edge-Kameras integriert werden, um die Verarbeitungsleistung direkt in der Kamera zu ermöglichen, anstatt Rohdaten in die Cloud oder zu zentralen Servern senden zu müssen. Dies reduziert die Bandbreitennutzung, verbessert die Datensicherheit und ermöglicht schnellere Reaktionszeiten.

Neben der verbesserten Analysegeschwindigkeit und Bildqualität sind photonische KI-Chips auch wesentlich energieeffizienter als klassische Prozessoren. Dies könnte dazu führen, dass autarke Überwachungssysteme mit geringem Stromverbrauch entstehen, die beispielsweise mit Solarenergie betrieben werden können – ideal für abgelegene Standorte oder mobile Sicherheitssysteme. Zudem könnten KI-gestützte Videoüberwachungssysteme dank photonischer Technologie auch für präventive Sicherheit genutzt werden, indem sie potenziell gefährliche Situationen bereits erkennen, bevor sie eskalieren.

Insgesamt werden photonische KI-Chips die Videoüberwachung auf ein völlig neues Level heben: Schnellere Verarbeitung, bessere Bildanalyse, geringere Energieanforderungen und eine präzisere Objekterkennung in Echtzeit. Damit sind sie ein Schlüsselbaustein für die Zukunft der intelligenten Sicherheitsüberwachung.

Fazit: Photonische KI-Chips – Die Zukunft der Hochleistungs-KI

Photonische KI-Chips stellen einen revolutionären technologischen Fortschritt dar, der die Grenzen herkömmlicher Halbleiterarchitekturen durchbricht. Durch die Nutzung von Licht (Photonen) statt Elektronen ermöglichen sie eine beispiellose Rechenleistung, da sie Daten mit Lichtgeschwindigkeit und nahezu ohne Energieverluste verarbeiten. Diese Eigenschaft macht sie besonders attraktiv für Anwendungen, die enorme Rechenkapazitäten erfordern, wie künstliche Intelligenz, maschinelles Lernen, Videoüberwachung, Hochleistungsrechnen und Quantenkommunikation.

Einer der größten Vorteile photonischer Chips ist ihre parallele Verarbeitungsfähigkeit, die durch Wavelength Division Multiplexing (WDM) ermöglicht wird. Dadurch können mehrere Berechnungen gleichzeitig ausgeführt werden, was die Effizienz und Skalierbarkeit von KI-Modellen erheblich steigert. Diese Fähigkeit ist insbesondere für Deep Learning, Big Data-Analysen und Echtzeit-Entscheidungsprozesse entscheidend, bei denen herkömmliche Chips oft durch hohe Latenzen und begrenzte Rechenleistung ausgebremst werden.

Zusätzlich bieten photonische Chips eine hervorragende Energieeffizienz, da sie weniger Wärme erzeugen und keinen elektrischen Widerstand aufweisen. Dies führt zu einem deutlich reduzierten Stromverbrauch, was insbesondere für Rechenzentren, Edge Computing und mobile KI-Anwendungen von großer Bedeutung ist. Die geringere Wärmeentwicklung macht aufwendige Kühlungssysteme überflüssig und senkt somit die Betriebskosten von Hochleistungssystemen erheblich.

Die Einflussbereiche photonischer KI-Chips sind enorm:

- In der Videoüberwachung ermöglichen sie schnellere und präzisere Bildanalysen, wodurch Sicherheitslösungen in Echtzeit reagieren können.

- In autonomen Fahrzeugen können sie große Mengen an Sensordaten in Millisekunden verarbeiten und so für eine sichere und zuverlässige Navigation sorgen.

- In medizinischen Anwendungen könnten photonische Chips komplexe Diagnosen und Bildanalysen beschleunigen und so zu früheren Erkennungen von Krankheiten beitragen.

Obwohl photonische KI-Chips noch in der Entwicklungsphase sind, ist ihr Potenzial unbestreitbar. Mit zunehmender Forschung und Investition wird diese Technologie die Rechenwelt nachhaltig verändern und neue Maßstäbe für Geschwindigkeit, Effizienz und Skalierbarkeit setzen. Sie könnten nicht nur bestehende elektronische Chips in vielen Bereichen ersetzen, sondern auch völlig neue Anwendungsmöglichkeiten eröffnen, die bisher aufgrund von Energie- und Rechenkapazitätsgrenzen nicht realisierbar waren.

Photonische KI-Chips sind der Schlüssel zu einer neuen Ära der Hochleistungs-KI – schneller, effizienter und nachhaltiger als je zuvor.

Kritische Schlussbetrachtung: Herausforderungen und Risiken photonischer KI-Chips

Obwohl photonische KI-Chips enormes Potenzial für die Zukunft der Datenverarbeitung bieten, gibt es auch technologische, wirtschaftliche und gesellschaftliche Herausforderungen, die nicht unterschätzt werden dürfen. Der Übergang von klassischen Halbleiterchips zu photonischen Prozessoren ist kein einfacher Prozess, da sowohl die Herstellung, Implementierung als auch die Anpassung bestehender Infrastrukturen erhebliche Hürden mit sich bringen.

1. Technologische Herausforderungen und Entwicklungsstand

Photonische Chips befinden sich noch in einem frühen Entwicklungsstadium und sind weit davon entfernt, auf breiter Ebene Silizium-basierte Prozessoren zu ersetzen. Derzeit gibt es nur eine begrenzte Anzahl von funktionierenden Prototypen, die in spezialisierten Forschungsumgebungen getestet werden. Die Integration photonischer Schaltkreise in bestehende Computersysteme stellt eine große Herausforderung dar, da herkömmliche Hardware und Software für elektrische Signale optimiert sind. Die Anpassung an eine lichtbasierte Datenverarbeitung erfordert neue Architekturen, Algorithmen und Produktionsverfahren, die noch nicht vollständig ausgereift sind.

2. Kosten und wirtschaftliche Faktoren

Ein weiteres großes Hindernis ist der hohe Produktionsaufwand. Während klassische Halbleiterchips über Jahrzehnte optimiert und kosteneffizient gefertigt werden können, erfordert die Entwicklung photonischer Chips neue Fertigungstechnologien und Materialien, die derzeit sehr teuer und komplex sind. Dies könnte dazu führen, dass nur große Konzerne mit ausreichender finanzieller Kraft Zugang zu dieser Technologie haben, wodurch eine Monopolisierung entstehen könnte. Zudem stellt sich die Frage, ob Unternehmen und Rechenzentren bereit sind, in eine völlig neue Technologie zu investieren, wenn klassische KI-Beschleuniger wie GPUs, TPUs und Quantenchips weiterhin leistungsstark weiterentwickelt werden.

3. Software-Kompatibilität und Infrastruktur

Eine der größten Herausforderungen ist die Integration photonischer Chips in bestehende Softwaresysteme. Bisher sind KI-Modelle und Algorithmen für elektronische Chips optimiert. Ein Wechsel auf photonische Hardware würde bedeuten, dass neue Programmiersprachen, Schnittstellen und Software-Optimierungen entwickelt werden müssen. Dies könnte dazu führen, dass Unternehmen zögern, auf photonische Chips umzusteigen, da die Anpassung von KI-Architekturen hohe Kosten und Entwicklungsaufwand erfordert.

4. Energieeffizienz vs. Kühlung

Zwar haben photonische Chips das Potenzial, weniger Wärme zu erzeugen und energieeffizienter zu sein, doch der Vorteil ist nicht uneingeschränkt. Die Schnittstellen zwischen photonischen und elektronischen Bauteilen benötigen weiterhin elektrische Umwandlungsprozesse, die wiederum Energie verbrauchen. Solange photonische Chips nicht vollständig autonom arbeiten, bleibt ein Hybrid-Ansatz notwendig, der die volle Energieeffizienz der Technologie einschränken könnte.

5. Sicherheit und neue Risiken

Eine weitere kritische Frage ist die Sicherheit photonischer Chips. Während klassische Prozessoren bereits gut gegen Angriffe geschützt sind, sind photonische Chips eine komplett neue Technologie, für die es noch kaum Sicherheitsstandards gibt. Die Manipulation von Lichtsignalen oder die Abhörbarkeit optischer Datenübertragungen könnten neue Angriffsmöglichkeiten für Hacker bieten. Zudem ist unklar, wie zuverlässig photonische Chips in sicherheitskritischen Anwendungen wie militärischer KI, in der Raumfahrt, in Finanzsystemen oder in der medizinischen Diagnostik funktionieren.

Zusammenfassung: Revolution mit Herausforderungen

Photonische KI-Chips haben das Potenzial, eine neue Ära der Rechenleistung einzuläuten, doch es gibt zahlreiche Herausforderungen, die vor einer großflächigen Einführung bewältigt werden müssen. Die Technologie steckt noch in den Anfängen, ist teuer in der Produktion und benötigt eine komplett neue Software-Infrastruktur. Zudem sind Fragen der Sicherheit, Skalierbarkeit und langfristigen Energieeffizienz noch nicht geklärt. Während photonische Chips in spezialisierten Hochleistungsanwendungen möglicherweise eine Revolution auslösen könnten, bleibt unklar, ob sie in absehbarer Zeit herkömmliche Halbleiterprozessoren in breitem Maßstab ersetzen können.

Die Zukunft wird zeigen, ob es gelingt, diese Herausforderungen zu bewältigen – oder ob photonische Chips eine Nischenlösung für hochspezialisierte Anwendungen bleiben, während klassische Siliziumchips weiterhin dominieren.

NUTZUNG | HAFTUNG

Trotz sorgfältiger Kontrolle übernehmen wir keine Gewähr für die Richtigkeit und Vollständigkeit der Inhalte.

ARTPEC: Intelligente Technologie hinter moderner Videoüberwachung

Der ARTPEC (Axis Real-Time Picture Encoder) System-on-Chip (SoC) ist das technologische Herzstück der Netzwerkkameras von Axis Communications und wurde speziell für die anspruchsvollen Anforderungen der Videoüberwachung entwickelt. Mit seiner Kombination aus leistungsstarker Bildverarbeitung, fortschrittlicher Videokompression und integrierter KI-Analyse setzt ARTPEC seit Jahren Maßstäbe in der Branche. Der Chip ermöglicht es den Kameras, Videos in höchster Qualität aufzunehmen, zu verarbeiten und zu analysieren – und das in Echtzeit. Dabei stehen nicht nur eine brillante Bildqualität, sondern auch Funktionen wie Rauschunterdrückung, dynamische Kontrasteinstellung (WDR) und eine zuverlässige Leistung bei schwierigen Lichtverhältnissen im Mittelpunkt.

ARTPEC-SoCs unterstützen die neuesten Videokompressionsstandards wie H.264 und H.265, kombiniert mit der von Axis entwickelten Zipstream-Technologie, die die Bandbreiten- und Speicheranforderungen reduziert, ohne Abstriche bei der Bildqualität zu machen. Diese Effizienz ist besonders wichtig in Szenarien, in denen große Datenmengen verarbeitet und gespeichert werden müssen. Gleichzeitig ermöglicht die Integration von Edge-Computing-Fähigkeiten, dass die Kameras direkt vor Ort komplexe Analysen durchführen können. Diese KI-gestützten Funktionen umfassen unter anderem die Erkennung von Objekten und Personen, Bewegungsanalysen und Verhaltensmustererkennung – alles ohne externe Server, was die Verarbeitung beschleunigt und die Netzwerklast minimiert.

Sicherheit ist ein zentraler Bestandteil des ARTPEC-Designs. Der Chip ist mit fortschrittlichen Sicherheitsfunktionen ausgestattet, darunter sichere Boot-Prozesse, hardwarebasierte Verschlüsselung und manipulationssichere Architekturen, die vor Cyberangriffen und unerlaubtem Zugriff schützen. Diese Sicherheitsvorkehrungen machen die Kameras nicht nur leistungsstark, sondern auch vertrauenswürdig für den Einsatz in sensiblen Umgebungen.

Durch kontinuierliche Weiterentwicklung hat Axis mit ARTPEC eine Plattform geschaffen, die nicht nur die Anforderungen von heute erfüllt, sondern auch für zukünftige Herausforderungen in der Videoüberwachung gewappnet ist. Vom Einsatz in Smart Cities über industrielle Anwendungen bis hin zu kritischen Infrastrukturen – ARTPEC bildet die Grundlage für leistungsfähige, effiziente und sichere Netzwerkkameras, die weltweit eingesetzt werden.

ARTPEC in der 9. Generation

Der ARTPEC-9, die neueste Generation des von Axis Communications entwickelten System-on-Chip (SoC), stellt einen bedeutenden technologischen Fortschritt in der Videoüberwachung dar. Dieses speziell für Netzwerkkameras optimierte SoC wurde entwickelt, um die steigenden Anforderungen an Bildqualität, Verarbeitungsgeschwindigkeit, künstliche Intelligenz und Sicherheit zu erfüllen. Mit dem ARTPEC-9 wird Edge-Computing auf ein neues Niveau gehoben: Der Chip ermöglicht die Ausführung von Deep-Learning-Algorithmen direkt in der Kamera, was präzise Videoanalysen wie Objekterkennung, Klassifizierung von Personen oder Fahrzeugen und Verhaltensanalysen in Echtzeit erlaubt. Dies reduziert die Abhängigkeit von externen Servern, verringert die Latenzzeiten und schont die Netzwerkkapazitäten.

Die Bildverarbeitungstechnologie des ARTPEC-9 ist darauf ausgelegt, selbst unter schwierigsten Lichtverhältnissen optimale Ergebnisse zu liefern. Funktionen wie Lightfinder 2.0 für herausragende Leistung bei schwachem Licht und verbesserte Wide Dynamic Range (WDR)-Technologien sorgen dafür, dass Details klar und gestochen scharf bleiben, auch in Szenarien mit hohem Kontrast. Hinzu kommt eine verbesserte Rauschunterdrückung, die die Bildqualität bei Dunkelheit weiter optimiert.

Ein weiterer Schwerpunkt liegt auf der Datensicherheit. Der ARTPEC-9 integriert fortschrittliche Verschlüsselungsmechanismen und hardwarebasierte Sicherheitslösungen, wie sichere Boot-Prozesse und Schutz vor unautorisierten Zugriffen, um den wachsenden Bedrohungen durch Cyberangriffe entgegenzuwirken. Diese Sicherheitsfunktionen machen den Chip besonders geeignet für den Einsatz in sensiblen Bereichen wie kritischen Infrastrukturen, dem öffentlichen Sektor oder hochfrequentierten Unternehmensumgebungen.

Effizienz wird durch den H.265-Videokompressionsstandard in Kombination mit Axis Zipstream-Technologie sichergestellt. Diese Kombination reduziert den Bandbreiten- und Speicherbedarf erheblich, ohne Kompromisse bei der Bildqualität einzugehen. Dadurch wird der ARTPEC-9 zum idealen SoC für Anwendungen, bei denen hohe Auflösungen und lange Speicherzeiten erforderlich sind.

Mit seiner leistungsstarken Architektur und zukunftssicheren Technologie stellt der ARTPEC-9 einen Meilenstein in der Entwicklung von Netzwerkkameras dar. Er bietet nicht nur die Grundlage für innovative Sicherheitslösungen, sondern setzt auch neue Maßstäbe in puncto Effizienz, Bildqualität und Datenschutz. Der ARTPEC-9 zeigt eindrucksvoll, wie Axis seine Vision einer starken, technologisch führenden Sicherheitsbranche weiter vorantreibt.

ARTPEC-9: Pionierarbeit mit AV1-Codec für effiziente Videoüberwachung

Der ARTPEC-9 markiert einen weiteren Meilenstein in der Videosicherheit, indem er als erstes System-on-Chip (SoC) den AV1-Videocodec unterstützt – einen modernen, quelloffenen Standard, der von der Alliance for Open Media (AOM) entwickelt wurde. AV1 ist speziell darauf ausgelegt, die Effizienz der Videokompression erheblich zu steigern und gleichzeitig eine exzellente Bildqualität zu gewährleisten. Durch die Unterstützung dieses Codecs bietet der ARTPEC-9 eine zukunftssichere Lösung, die den wachsenden Anforderungen an Bandbreitenmanagement und Speicherplatz in der Videoüberwachung gerecht wird.

Der AV1-Codec ermöglicht eine bis zu 30 % höhere Kompressionsrate im Vergleich zu herkömmlichen Standards wie H.264 und H.265, ohne dass dies zu Qualitätseinbußen führt. Dies macht ihn besonders attraktiv für Anwendungen, bei denen große Datenmengen verarbeitet werden, wie etwa bei hochauflösenden Videos oder einer Vielzahl von Kameras in komplexen Netzwerken. Mit AV1 können Unternehmen Speicher- und Netzwerkkosten reduzieren, während sie gleichzeitig von einer besseren Videoqualität profitieren.

Die Integration von AV1 in den ARTPEC-9 bringt zudem Vorteile in Bezug auf Interoperabilität und Offenheit. Als quelloffener Standard bietet AV1 mehr Flexibilität und Freiheit von Lizenzgebühren, was insbesondere für Entwickler und Systemintegratoren interessant ist. Gleichzeitig wird der Codec von einer breiten Industrieallianz unterstützt, was seine Akzeptanz und zukünftige Verbreitung weiter fördert.

Mit der Unterstützung von AV1 beweist der ARTPEC-9 nicht nur seine technische Führungsposition, sondern auch seine Fähigkeit, aktuelle und zukünftige Marktanforderungen zu erfüllen. Diese Innovation unterstreicht Axis Engagement, effiziente, leistungsstarke und nachhaltige Technologien in der Videoüberwachung voranzutreiben, und positioniert ARTPEC-9 als wegweisende Lösung für die nächste Generation von Sicherheitskameras.

NUTZUNG | HAFTUNG

Trotz sorgfältiger Kontrolle übernehmen wir keine Gewähr für die Richtigkeit und Vollständigkeit der Inhalte.

Dahua Kameralogin: Subnetz Adresse ändern

Dahua Kameralogin: Um auf die Benutzeroberfläche Ihrer Dahua Überwachungskamera zuzugreifen, öffnen Sie zunächst einen Browser Ihrer Wahl, beispielsweise Google Chrome, Mozilla Firefox, Microsoft Edge oder Safari. Geben Sie anschließend die IP-Adresse des Geräts direkt in die Adresszeile des Browsers ein. Bei Dahua-Kameras ist die werkseitig voreingestellte IP-Adresse in der Regel 192.168.1.108. Nachdem Sie diese Adresse eingegeben haben, drücken Sie die Eingabetaste, um die Verbindung herzustellen. Der Browser versucht nun, das Web-Interface der Kamera zu laden, über das Sie beispielsweise das Livebild ansehen, die Kamera konfigurieren oder Netzwerkeinstellungen ändern können.

Stellen Sie sicher, dass sich Ihr Computer oder mobiles Endgerät im gleichen lokalen Netzwerksegment befindet, also z. B. eine IP-Adresse wie 192.168.1.xxx verwendet. Falls dies nicht der Fall ist, wird die Kamera nicht erreichbar sein. In manchen Fällen kann es notwendig sein, die IP-Adresse der Kamera zunächst mithilfe eines Tools wie Dahua ConfigTool zu ermitteln oder anzupassen. Moderne Dahua-Kameras sind in der Regel mit aktuellen Webtechnologien kompatibel, jedoch kann bei bestimmten Geräten – insbesondere älteren Modellen – ein spezielles Browser-Plug-in erforderlich sein, das nur in bestimmten Browsern oder im Kompatibilitätsmodus funktioniert. Sollte sich das Web-Interface nicht öffnen oder korrekt anzeigen lassen, empfiehlt sich ein Blick in die Dokumentation des Herstellers oder der Einsatz eines unterstützten Browsers.

Dahua Kameralogin: So passen Sie Ihre IP-Adresse dem Gerätesubnetz an

Damit Sie eine direkte Verbindung zu Ihrer Überwachungskamera oder einem anderen netzwerkbasierten Gerät mit einer festen IP-Adresse im Bereich 192.168.1.x herstellen können, muss auch Ihr PC eine IP-Adresse aus demselben Subnetz verwenden. Nur so ist eine Kommunikation zwischen beiden Geräten möglich – insbesondere dann, wenn keine zentrale Netzwerkverteilung (wie ein DHCP-Server oder Router) vorhanden ist. In vielen Fällen, etwa beim erstmaligen Einrichten von Überwachungskameras, Netzwerkrekordern oder anderen sicherheitstechnischen Komponenten, ist eine manuelle Konfiguration der IP-Adresse Ihres Rechners erforderlich. Im Folgenden wird beschrieben, wie Sie die IP-Einstellungen Ihres PCs anpassen, um eine korrekte Verbindung zum Gerät mit der Standardadresse 192.168.1.108 herzustellen.

Windows:

- Netzwerk- und Interneteinstellungen öffnen:

- Rechtsklick auf das Netzwerksymbol in der Taskleiste → Netzwerk- und Interneteinstellungen öffnen → Erweiterte Netzwerkeinstellungen → Adapteroptionen ändern.

- Netzwerkadapter auswählen:

- Finden Sie den aktiven Netzwerkadapter (LAN oder WLAN), der mit dem Gerät verbunden ist.

- Rechtsklicken Sie darauf und wählen Sie Eigenschaften.

- IP-Einstellungen bearbeiten:

- Suchen Sie in der Liste nach Internetprotokoll Version 4 (TCP/IPv4).

- Wählen Sie es aus und klicken Sie auf Eigenschaften.

- Manuelle IP-Adresse einstellen:

- Wählen Sie Folgende IP-Adresse verwenden:

- IP-Adresse: Geben Sie eine Adresse im gleichen Subnetz ein wie das Gerät. Beispiel: 192.168.1.100.

- Subnetzmaske: Setzen Sie sie auf 255.255.255.0.

- Standardgateway: Geben Sie 192.168.1.1 (oder leer lassen) ein.

- Wählen Sie Folgende IP-Adresse verwenden:

- Einstellungen speichern:

- Klicken Sie auf OK, um die Änderungen zu speichern.

- Schließen Sie alle Fenster.

- Überprüfung:

- Öffnen Sie ein Terminal (Windows-Taste + R → „cmd“ → Enter).

- Geben Sie ping 192.168.1.108 ein, um die Verbindung zum Gerät zu testen.

macOS:

- Netzwerkeinstellungen öffnen:

- Gehen Sie zu Systemeinstellungen → Netzwerk.

- Netzwerk auswählen:

- Wählen Sie die aktive Verbindung (z. B. „Ethernet“ oder „WLAN“) aus.

- Manuelle IP-Adresse einstellen:

- Klicken Sie auf Erweitert → TCP/IP.

- Ändern Sie die Einstellung von DHCP zu Manuell.

- Geben Sie Folgendes ein:

- IP-Adresse: z. B. 192.168.1.100.

- Subnetzmaske: 255.255.255.0.

- Router (Gateway): 192.168.1.1.

- Einstellungen speichern:

- Klicken Sie auf OK und anschließend auf Anwenden.

- Verbindung testen:

- Öffnen Sie das Terminal und geben Sie ping 192.168.1.108 ein, um die Verbindung zum Gerät zu prüfen.

Einstellungen rückgängig machen:

Sobald Sie das Gerät in Ihr Heimnetzwerk integriert haben, stellen Sie die IP-Adresse des PCs wieder auf automatisch beziehen (DHCP) zurück:

- Windows: Wählen Sie in den IPv4-Einstellungen IP-Adresse automatisch beziehen.

- macOS: Setzen Sie die TCP/IP-Einstellung auf DHCP.

Fazit

Durch diese Schritte bringen Sie Ihren PC ins gleiche Subnetz wie das Gerät (192.168.1.x), sodass Sie auf dessen Einstellungen zugreifen und die IP-Adresse des Geräts anpassen können.

NUTZUNG | HAFTUNG

Trotz sorgfältiger Kontrolle übernehmen wir keine Gewähr für die Richtigkeit und Vollständigkeit der Inhalte.

Unterschied zwischen Time-of-Flight (ToF) und Light Detection and Ranging (LiDAR)

Time-of-Flight (ToF) und LiDAR sind zwei Technologien, die auf der Messung der Laufzeit von Lichtimpulsen basieren, aber in ihren Anwendungen und Eigenschaften unterschiedliche Stärken zeigen. Während Time-of-Flight in kompakten Geräten für Nahbereichsanwendungen wie der 3D-Gesichtserkennung eingesetzt wird, ermöglicht LiDAR hochpräzise 3D-Mapping und Navigation über größere Entfernungen. Beide Technologien spielen eine wichtige Rolle in der modernen Sensorik und werden in verschiedenen Branchen eingesetzt.

INHALTSVERZEICHNIS

Was ist Time-of-Flight (ToF)

Time-of-Flight (ToF) ist eine innovative Technologie zur präzisen Messung von Entfernungen, die auf der Laufzeitmessung von Lichtimpulsen basiert. Ein Time-of-Flight-Sensor sendet Licht, meist im Infrarotbereich, von einer Quelle aus, das auf ein Objekt trifft, reflektiert wird und anschließend von einem Sensor erfasst wird. Die Zeit, die das Licht für diesen Hin- und Rückweg benötigt, wird gemessen und mit der Lichtgeschwindigkeit verrechnet, um die Entfernung zum Objekt zu berechnen. Dieses Prinzip ermöglicht die Erstellung von Tiefenkarten und dreidimensionalen Bildern.

Die Time-of-Flight-Technologie ist besonders für Anwendungen auf kurze bis mittlere Entfernungen geeignet, typischerweise im Bereich von wenigen Zentimetern bis hin zu einigen Metern, und wird häufig in Smartphones, 3D-Kameras und Robotiksystemen eingesetzt.

Ein entscheidender Vorteil von Time-of-Flight ist seine Fähigkeit, Tiefendaten in Echtzeit zu erfassen, was es ideal für Szenarien wie Gesichtserkennung, Gestensteuerung oder Augmented Reality macht. Zudem ist Time-of-Flight unabhängig von der Textur oder Farbe eines Objekts und kann in unterschiedlichsten Lichtverhältnissen arbeiten, sogar in völliger Dunkelheit, da es sein eigenes Licht aussendet.

Moderne Time-of-Flight-Sensoren sind energieeffizient und kompakt, was sie für den Einsatz in mobilen Geräten besonders attraktiv macht. Trotz seiner Vielseitigkeit gibt es auch Herausforderungen, wie die Begrenzung der Reichweite und mögliche Interferenzen durch andere Lichtquellen in der Umgebung.

Time-of-Flight (ToF)-Technologie verwendet typischerweise LED- oder Laserlicht im Infrarotbereich als Lichtquelle. Diese Wahl hat mehrere Vorteile, darunter die Unsichtbarkeit des Lichts für das menschliche Auge und eine geringere Empfindlichkeit gegenüber Umgebungslicht, was ToF-Systeme in verschiedenen Lichtverhältnissen zuverlässig macht.

Zudem ist Time-of-Flight unabhängig von der Textur oder Farbe eines Objekts und kann sogar in völliger Dunkelheit arbeiten, da es sein eigenes Licht aussendet.

Die Lichtquellen in ToF-Systemen sind oft weniger leistungsstark als die von LiDAR, da sie für Anwendungen optimiert sind, die kurze bis mittlere Entfernungen abdecken, typischerweise im Bereich von wenigen Zentimetern bis zu einigen Metern.

Dadurch sind ToF-Sensoren kompakt, energieeffizient und kostengünstig, was sie ideal für den Einsatz in mobilen Geräten, Robotik oder Augmented Reality macht. Diese Begrenzung der Leistung sorgt jedoch dafür, dass ToF eher für Nahbereichsanwendungen wie Gestensteuerung, Gesichtserkennung oder Indoor-Navigation geeignet ist, während größere Reichweiten nur eingeschränkt unterstützt werden.

Dennoch hat sich Time-of-Flight als Schlüsseltechnologie für innovative Anwendungen etabliert, die schnelle, präzise und zuverlässige Entfernungsmessungen erfordern.

Was ist Light Detection and Ranging (LiDAR)

Light Detection and Ranging (LiDAR) ist eine fortschrittliche Technologie zur präzisen dreidimensionalen Erfassung von Umgebungen und Objekten. Sie basiert auf der Messung der Laufzeit von Laserimpulsen, die von einer Quelle ausgesendet, von Objekten reflektiert und schließlich von einem Empfänger detektiert werden. Durch die genaue Bestimmung der Zeit, die das Licht für die Hin- und Rückreise benötigt, wird die Entfernung zum reflektierenden Objekt berechnet. LiDAR-Systeme können Millionen von Messpunkten pro Sekunde aufnehmen und daraus hochauflösende 3D-Punktwolken erstellen, die die Geometrie einer Umgebung oder eines Objekts in beeindruckendem Detail darstellen.

LiDAR wird häufig für großflächige Anwendungen eingesetzt, die eine hohe Präzision und Reichweite erfordern. Beispiele sind autonome Fahrzeuge, bei denen es zur Hinderniserkennung und Navigation dient, sowie die Kartierung und Vermessung von Landschaften, Gebäuden und Infrastruktur. In der Geodäsie wird LiDAR verwendet, um detaillierte topografische Karten zu erstellen, und in der Umweltforschung hilft es, Wälder, Küstenlinien und andere natürliche Gebiete zu analysieren.

Zudem werden LiDAR-Systeme in der Sicherheitstechnik insbesondere beim Perimeterschutz eingesetzt. Diese Vielseitigkeit verdankt die Technologie ihrer Fähigkeit, Entfernungen von wenigen Metern bis hin zu mehreren Hundert Metern mit millimetergenauer Präzision zu messen.

Ein besonderer Vorteil von LiDAR ist seine Fähigkeit, unabhängig von Umgebungslichtbedingungen zu arbeiten, da es aktiv Licht aussendet. Es kann selbst, ähnlich wie Time-of-Flight (ToF), in völliger Dunkelheit oder unter schwierigen Wetterbedingungen zuverlässig arbeiten. Moderne LiDAR-Systeme nutzen rotierende oder oszillierende Spiegel, um große Bereiche schnell zu scannen, oder Festkörper-LiDAR-Technologien, die kompakter und robuster sind.

Trotz seiner hohen Leistungsfähigkeit hat LiDAR auch Herausforderungen, darunter die hohe Kostenstruktur und die Empfindlichkeit gegenüber Interferenzen durch andere Laserquellen. Dennoch bleibt LiDAR ein unverzichtbares Werkzeug für Anwendungen, bei denen große Entfernungen, Genauigkeit und Detailtiefe entscheidend sind.

Unterschiede zwischen Time-of-Flight (ToF) und LiDAR: Technologien im Vergleich

Time-of-Flight (ToF) und LiDAR (Light Detection and Ranging) basieren auf dem gleichen physikalischen Prinzip der Laufzeitmessung von Lichtimpulsen, unterscheiden sich jedoch erheblich in ihrer Technologie, Anwendung und Reichweite. Time-of-Flight (ToF) ist eine Technologie zur Entfernungsmessung, bei der Lichtimpulse von einer Quelle ausgesendet, von einem Objekt reflektiert und von einem Sensor erfasst werden, um die Entfernung durch die Messung der Laufzeit zu bestimmen.

ToF wird oft in kompakten Geräten wie der Gesichtserkennung bei Zutrittskontrollsystemen eingesetzt und liefert Tiefenkarten oder 3D-Bilder für kurze bis mittlere Entfernungen, typischerweise im Bereich von wenigen Metern. Die Lichtquelle ist in der Regel eine LED oder ein Infrarot-Laser, die energieeffizient und für Anwendungen an der Edge, an der Datenquelle, geeignet sind.

LiDAR, hingegen, ist eine spezialisierte Anwendung der Time-of-Flight-Technologie, die hochleistungsfähige Laserstrahlen verwendet, um präzise dreidimensionale Punktwolken einer Umgebung zu erstellen. Es ist für größere Reichweiten optimiert, oft mehrere Hundert Meter, und wird in Bereichen wie der Sicherheitstechnik, in autonomen Fahrzeugen, bei der Geodäsie und der Umwelterfassung eingesetzt.

Light Detection and Ranging (LiDAR) Systeme können detaillierte 3D-Karten von Landschaften und Städten erstellen und spielen eine Schlüsselrolle in der Navigation und Hinderniserkennung. Während ToF für Szenarien entwickelt wurde, die Geschwindigkeit, Kompaktheit und geringeren Energieverbrauch erfordern, zeichnet sich LiDAR durch seine hohe Präzision und Fähigkeit aus, großflächige Umgebungen zu scannen. In der Praxis ergänzt sich die Verwendung von ToF und LiDAR oft, da Time-of-Flight für nahbereichsorientierte Anwendungen ideal ist, während LiDAR für anspruchsvollere, reichweitenstarke und detaillierte Analysen eingesetzt wird.

NUTZUNG | HAFTUNG

Trotz sorgfältiger Kontrolle übernehmen wir keine Gewähr für die Richtigkeit und Vollständigkeit der Inhalte.

Produkttest

Sie sind Hersteller von Sicherheitsprodukten, insbesondere von Komponenten für die Videoüberwachungstechnik und möchten, dass Ihre Artikel durch uns getestet und auf CCTV-check vorgestellt werden, dann besuchen Sie unser spezielles Angebot für Hersteller.

Technologie

Sie möchten in der Wissensdatenbank über eine spezielle Technologie berichten und einen Artikel veröffentlichen, dann nehmen Sie bitte über nachfolgenden Link Kontakt mit uns auf.